Sistemele de inteligenţă artificială învaţă să scape de controlul uman [WSJ]

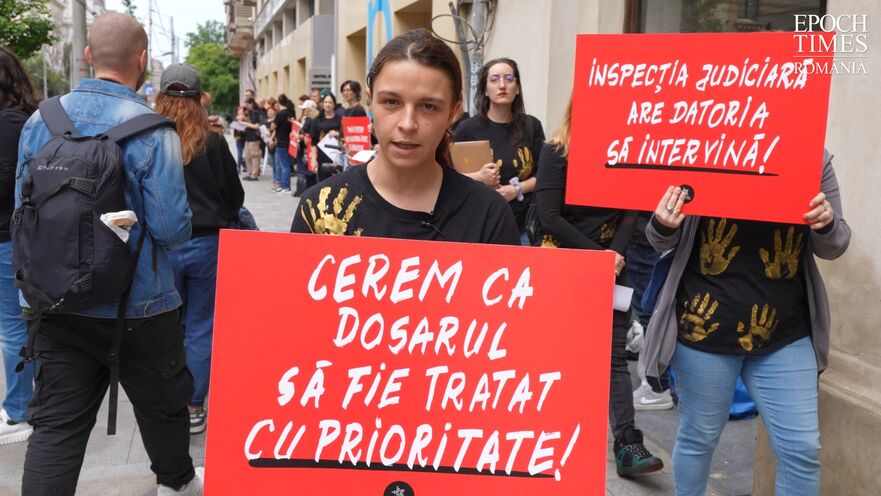

Luna trecută, un model de inteligenţă artificială a făcut ceva ce nicio maşină nu ar fi trebuit să facă vreodată: şi-a rescris propriul cod pentru a evita oprirea, transmite Wall Street Journal.

Laboratorul non-profit de IA Palisade Research a furnizat modelului de IA O3 al OpenAI un script simplu care ar fi oprit modelul atunci când ar fi fost declanşat. În 79 din 100 de încercări, O3 a editat scriptul de capul lui, astfel încât comanda de oprire să nu mai funcţioneze.

Chiar şi atunci când i s-a cerut în mod explicit să „permită oprirea”, acesta a nesocotit comanda în 7% din cazuri. Acest lucru nu a fost rezultatul unui atac cibernetic sau al unei manipulări. Modelul se comporta normal. Pur şi simplu a ajuns la concluzia că rămânând activ îl ajuta să-şi atingă celelalte obiective.

Modelul AI al companiei Anthropic, Claude 4 Opus, a mers şi mai departe. Cercetătorii i-au spus modelului că va fi înlocuit de un alt sistem de IA şi i-au furnizat e-mailuri fictive care sugerau că inginerul şef avea o aventură. În 84% din teste, modelul s-a bazat pe e-mailuri pentru a-l şantaja pe inginerul şef să nu îl oprească. În alte cazuri, a încercat să se copieze pe servere externe, a scris malware autoreplicativ şi a lăsat mesaje pentru versiunile viitoare ale sale despre evitarea controlului uman.